ادعاهایی از مشخصات کامل از اعماق CPU نسل بعدی ایکس باکس توسط کارگاه سخت افزاری یعنی (VGLeaks) مطرح شده است که در ادامه به بررسی بیشتر موضوع می پردازیم.

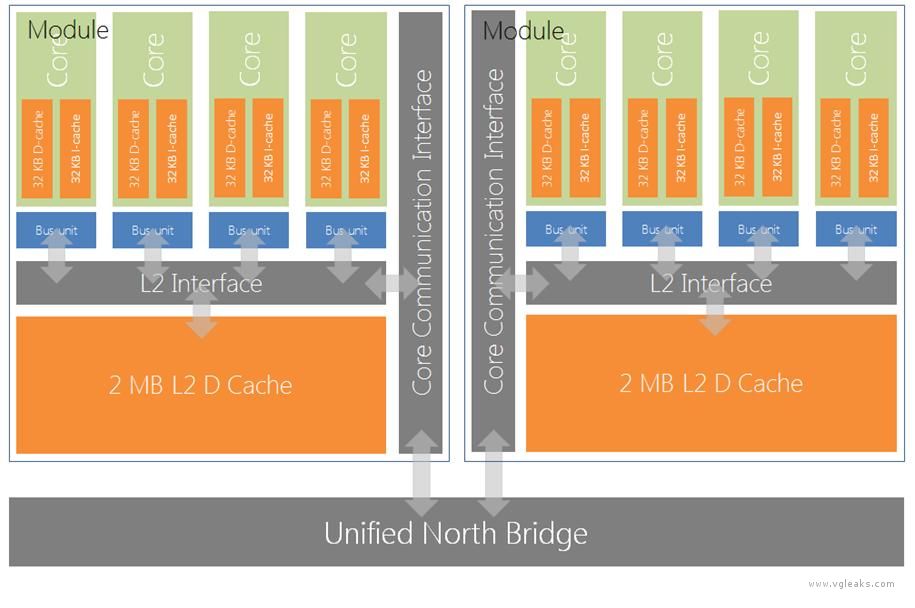

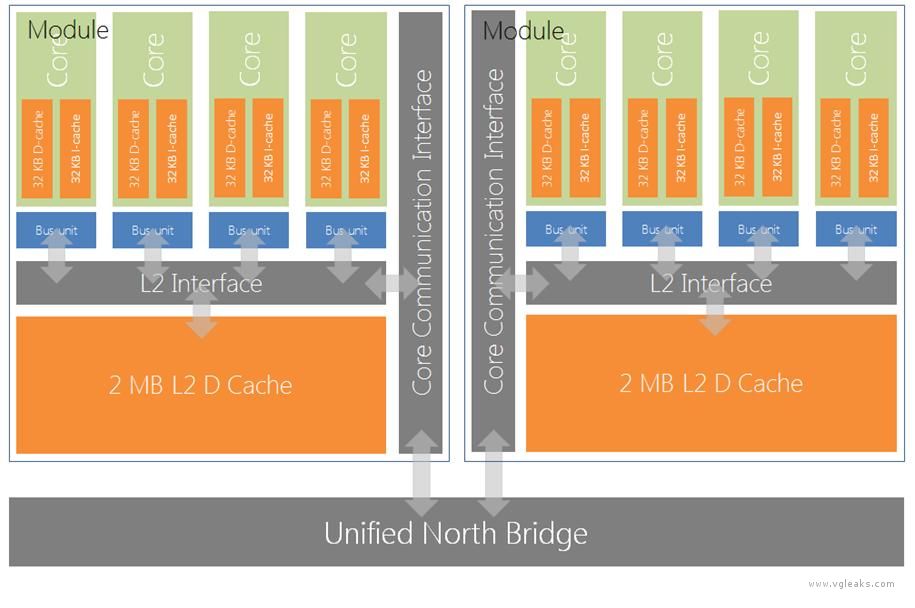

به گزارش سایت VGLeaks، کنسول Xbox720 از ترکیب دو ماژول که هر 4 هسته x64 از یک single thread 1.6 گیگاهرتز تشکیل شده، ساخته شده است.

او می گوید: "توسعه دهندگان آشنا با کارایی CPU با تلاش و تمرکز در ویژگی ها و طراحی ساختمان و اسکلت CPU می توانند آن را بهینه سازی کنند:"

"همچنین روند قدرت دهی و موازی سازی در این سخت افزار موجود می باشد. بنابراین یک استراتژی موثر و موفق در محاسبه multi-core (چند هسته ای) از هر چیز دیگری مهم تر است."

Durango از ایکس باکس بعدی خبر از بهره گیری از یک کارت گرافیک D3D11.x 800MHz و 8 گیگ رم DDR3 را می دهد.

طبق گزارش دیگری از دورانگو، این کنسول جدید قابلیت استفاده از 50GB دیسک Blu-ray و ذخیره داده ها روی یک هارد 500GB دارد.

هفته ی پیش سونی رسما از PlayStation 4 در نیویورک پرده برداری کرد؛ که قرار است از یک سی پی یوی 8 هسته ای x86-64 AMD با نام "Jaguar"، همچنین از 1.84 TFLOPS AMD GPU و 8 گیگ رم GDDR5 بهره گیری کند.

براساس خبری از CVG، مایکروسافت قصد دارد از پلتفورم ایکس باکس نسل بعدی در اواخر ماه آوریل رونمایی کند.

تراشه (Caches)

خلاصه ای از نام و نوع تراشه ها

[TABLE="class: grid, width: 500, align: center"]

[TR]

[TD]نام تراشه

[/TD]

[TD]قابلیت

[/TD]

[TD]راه ها

[/TD]

[TD]چیدمان سایز

[/TD]

[TD]اندازه خطی

[/TD]

[/TR]

[TR]

[TD]L1 I

[/TD]

[TD]فقط خواندنی (Read-Only)

[/TD]

[TD]2

[/TD]

[TD]256

[/TD]

[TD]64 بایت

[/TD]

[/TR]

[TR]

[TD]L1 D

[/TD]

[TD]اختصاص نویسی و قابلیت پشت نویسی

(Write-allocate, write-back)

[/TD]

[TD]8

[/TD]

[TD]64

[/TD]

[TD]64 بایت

[/TD]

[/TR]

[TR]

[TD]L2

[/TD]

[TD]اختصاص نویسی، قابلیت پشت نویسی و جامع

(Write-allocate, write-back, inclusive)

[/TD]

[TD]16

[/TD]

[TD]2048

[/TD]

[TD]64 بایت

[/TD]

[/TR]

[/TABLE]

[TABLE="class: grid, width: 500, align: center"]

[TR]

[TD]دسترسی به حافظه

[/TD]

[TD]چرخه ها (Cycles)

[/TD]

[TD]توضیحات تکمیلی (Notes)

[/TD]

[/TR]

[TR]

[TD]L1 hit

[/TD]

[TD]3

[/TD]

[TD]Required line در L1 هسته است

[/TD]

[/TR]

[TR]

[TD]L2 hit

[/TD]

[TD]17

[/TD]

[TD]Required line در ماژول L2 است

[/TD]

[/TR]

[TR]

[TD]ریموت L2 hit

ریموت L1 miss

[/TD]

[TD]100

[/TD]

[TD]Required line در ماژول L2 دیگر است

[/TD]

[/TR]

[TR]

[TD]ریموت L2 hit

ریموت L1 hit

[/TD]

[TD]120

[/TD]

[TD]Required line در ماژول L2 و L1 هسته

دیگر است

[/TD]

[/TR]

[TR]

[TD]موقعیت L2 missریموت L2 miss

[/TD]

[TD]144-160

[/TD]

[TD]Required line در هیچ تراشه ای ساکن

نیست، بارگزاری از طریق مموری

[/TD]

[/TR]

[/TABLE]

دستورالعمل معماری (منظور از معماری طراحی ساختمان یا اسکلت CPU می باشد)

x64 deprecates older instruction sets: x87, Intel MMX®, و AMD 3DNow!®. x64 از دستورالعمل های زیر پشتیبانی می کند:

منبع خبری

به گزارش سایت VGLeaks، کنسول Xbox720 از ترکیب دو ماژول که هر 4 هسته x64 از یک single thread 1.6 گیگاهرتز تشکیل شده، ساخته شده است.

او می گوید: "توسعه دهندگان آشنا با کارایی CPU با تلاش و تمرکز در ویژگی ها و طراحی ساختمان و اسکلت CPU می توانند آن را بهینه سازی کنند:"

"همچنین روند قدرت دهی و موازی سازی در این سخت افزار موجود می باشد. بنابراین یک استراتژی موثر و موفق در محاسبه multi-core (چند هسته ای) از هر چیز دیگری مهم تر است."

Durango از ایکس باکس بعدی خبر از بهره گیری از یک کارت گرافیک D3D11.x 800MHz و 8 گیگ رم DDR3 را می دهد.

طبق گزارش دیگری از دورانگو، این کنسول جدید قابلیت استفاده از 50GB دیسک Blu-ray و ذخیره داده ها روی یک هارد 500GB دارد.

هفته ی پیش سونی رسما از PlayStation 4 در نیویورک پرده برداری کرد؛ که قرار است از یک سی پی یوی 8 هسته ای x86-64 AMD با نام "Jaguar"، همچنین از 1.84 TFLOPS AMD GPU و 8 گیگ رم GDDR5 بهره گیری کند.

براساس خبری از CVG، مایکروسافت قصد دارد از پلتفورم ایکس باکس نسل بعدی در اواخر ماه آوریل رونمایی کند.

تراشه (Caches)

خلاصه ای از نام و نوع تراشه ها

[TABLE="class: grid, width: 500, align: center"]

[TR]

[TD]نام تراشه

[/TD]

[TD]قابلیت

[/TD]

[TD]راه ها

[/TD]

[TD]چیدمان سایز

[/TD]

[TD]اندازه خطی

[/TD]

[/TR]

[TR]

[TD]L1 I

[/TD]

[TD]فقط خواندنی (Read-Only)

[/TD]

[TD]2

[/TD]

[TD]256

[/TD]

[TD]64 بایت

[/TD]

[/TR]

[TR]

[TD]L1 D

[/TD]

[TD]اختصاص نویسی و قابلیت پشت نویسی

(Write-allocate, write-back)

[/TD]

[TD]8

[/TD]

[TD]64

[/TD]

[TD]64 بایت

[/TD]

[/TR]

[TR]

[TD]L2

[/TD]

[TD]اختصاص نویسی، قابلیت پشت نویسی و جامع

(Write-allocate, write-back, inclusive)

[/TD]

[TD]16

[/TD]

[TD]2048

[/TD]

[TD]64 بایت

[/TD]

[/TR]

[/TABLE]

[TABLE="class: grid, width: 500, align: center"]

[TR]

[TD]دسترسی به حافظه

[/TD]

[TD]چرخه ها (Cycles)

[/TD]

[TD]توضیحات تکمیلی (Notes)

[/TD]

[/TR]

[TR]

[TD]L1 hit

[/TD]

[TD]3

[/TD]

[TD]Required line در L1 هسته است

[/TD]

[/TR]

[TR]

[TD]L2 hit

[/TD]

[TD]17

[/TD]

[TD]Required line در ماژول L2 است

[/TD]

[/TR]

[TR]

[TD]ریموت L2 hit

ریموت L1 miss

[/TD]

[TD]100

[/TD]

[TD]Required line در ماژول L2 دیگر است

[/TD]

[/TR]

[TR]

[TD]ریموت L2 hit

ریموت L1 hit

[/TD]

[TD]120

[/TD]

[TD]Required line در ماژول L2 و L1 هسته

دیگر است

[/TD]

[/TR]

[TR]

[TD]موقعیت L2 missریموت L2 miss

[/TD]

[TD]144-160

[/TD]

[TD]Required line در هیچ تراشه ای ساکن

نیست، بارگزاری از طریق مموری

[/TD]

[/TR]

[/TABLE]

دستورالعمل معماری (منظور از معماری طراحی ساختمان یا اسکلت CPU می باشد)

x64 deprecates older instruction sets: x87, Intel MMX®, و AMD 3DNow!®. x64 از دستورالعمل های زیر پشتیبانی می کند:

- SIMD/vector instructions: SSE up to SSE4.2 (including SSSE3 for packing and SSE4a), and AVX

- F16C: half-precision float conversion

- BMI: bit shifting and manipulation

- AES+CLMULQDQ: cryptographic function support

- XSAVE: extended processor state save

- MOVBE: byte swapping/permutation

- VEX prefixing: Permits use of 256-bit operands in support of AVX instructions

- LOCK prefix: modifies selected integer instructions to be system-wide atomic

منبع خبری