اخبار مرتبط به PC (سخت افزار و نرم افزار) اینجا قرار گرفته میشه . مباحث متفرقه از جمله vs ، سیاسی و .... ممنوع ـه در صورت تخطی برخورد میشه.

با تشکر

با تشکر

درود

تست 6 ماه پیش

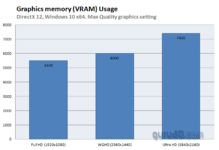

rtx 3080 مصرف vram هم در 4k حدود 7 گیگ / مصرف gpu حدود 360w

View attachment 205334

دقیقا همون کانال و rtx 3080 و نسخه enhanced edition

مصرف vram در 4k حدود 8.3 گیگ / مصرف gpu حدود 430w

View attachment 205335

البته به لطف dlss مصرف vram و فریم بهتر می شه

8 گیگ vram برای 4k مناسب نیست /1440p هم شاید تا 2022

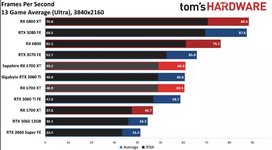

ویدیو ها رو تو SPOILER فرستادماول از همه باید بگم من منظورم بنچمارک تامز هاردور بودش در حالت 1440p در حالت 4K که اصلا تست نشده .(بله این دوتا کارت 4K نیستند)

مورد دوم ... شرایط مقایسه این دو ورژن ... (ورژن جدید کلا برای ریتریسینگ بهینه شده و تغییرات کلی هم داشته) را چطوری مقایسه کردید در صورتی که دوتا سین (فریم ) متفاوت با سخت افزار متفاوت! عجیبه !

اطلاع هم دارید که پردازنده ی 5600X یکی از قویترین ها هستش در مقابل 3600 وانیلی ...(CPU بهتر = گلوگاه کمتر = GPU Usage بیشتر = فرکانس بیشتر = وات بیشتر = حرارت بیشتر )

و اگر بررسی DF را دیده باشید متوجه میشید که ورژن جدید بهینه تر هستش ! (نتیجه ی محصول با چیزی که من گفتم تفاوتی نداره)

در نهایت اگر حتی اگر دوتا صحنه ی مشابه باشند کارهای عجیب و غریب AMD را توی بخش GPU توجیه نمیکنه ...

مجبور شدم یکم بیشتر دقت کنم توی تصویر ..

شما بدون دیوایس مخصوص نمیتونید مصرف برق GPU را اندازه گیری کنید اون مصرف مجموعه چند تا قطعه هستش

و اینکه به فرکانس CPU دقت کنید ... !

حقیقتش حوصلم نکشید بقیه موارد را هم تحلیل کنم.

دو تا بنچمارک با شرایط متفاوت اصلا منبع خوبی نیست ! ادامه ی این بحث به جایی نمیرسه .ویدیو ها رو تو SPOILER فرستادم

vram تقریبا همین حدود

5600x هم در حد 3600 حداکثر 10w بیشتر ( اون 80 درصد هم مصرف GPU نیست, دور فن )

موتور RE کلا vram بالایی می خواد

Resident Evil 3

View attachment 205342

RE8 هم از نظر بهینه سازی خارق العاده است و با کارت های مثل 2070 / RX 5700XT /2060S هم به راحتی 4K 60 فریم اجرا می شه

افزایش مصرف VRAM با تغییر نسل هم یه اتفاق طبیعیه , نسل قبل هم BLACK FLAG حداکثر 2 گیگ بود / یکسال بعد با UNITY به 3.5 تا 4 گیگ رسید

چقدر دقیق حساب کردید تفاوت مصرف دوتا CPU کاملا متفاوت را !5600x هم در حد 3600 حداکثر 10w بیشتر ( اون 80 درصد هم مصرف GPU نیست, دور فن )

بالا اشاره کردم موتور RE کلا vram بالایی می خواد , RE3 یه بازی خطی اما در 4K داره 7.4 گیگ مصرف می کنهدو تا بنچمارک با شرایط متفاوت اصلا منبع خوبی نیست ! ادامه ی این بحث به جایی نمیرسه .

در ضمن قبل از این بازی بازی های نسل جدید خیلی وقت هست موجود هستند بحث سر این بود که چطوری یک بازی با فضای محدود اینهمه Vram مصرف میکنه در مقابل بقیه بازی ها در صورتی که توی 1440 هم مشکل پیدا شده با رم 8 گیگ .... ! و اینکه بازی اول نسلی باشه یا آخر هاش .

در مورد بازی های AMD باند هم قبلا assassin's creed valhalla را داشتیم که مثلا تفاوت 3080 با 3070 یک چیز عجیب و غریبی بود ... ربطی هم به نسل جدید و رم بیشتر نداشتن .

AMD شدیدا توی این نسل عقب افتاده و دیگه بیشتر از این نمیشه منکر Raytracing و DLSS شد .

به همین منوال هم نمیشه برای سیاست مسخره انویدیا توی VRAM هم بهونه آورد .

ولی نه تا این حد که AMD این نقطه ضعف را به ما تحمیل کنه (اشتهای بالای Vram برای یک بازی پر از No-go area ...)

خیلی سادست انتظار مصرف کننده .... یک بازی با محیط و فضای محدود و مصرف Vram کمتر از یک بازی Open world

کلا AMD سیاستش شده کاهش سرعت حریف نه افزایش سرعت خودش و ... (البته توی GPU ها فعلا )

ویرایش :

نوشته ی شما ...

چقدر دقیق حساب کردید تفاوت مصرف دوتا CPU کاملا متفاوت را !

پس این تفاوت مصرف احتمالا بر میگرده به 3080 (کارت یکسان) با 1.6 درصد فرکانس بیشتر (و البته 20 درصد هم سرعت دستی فن بیشتر )

amd الان دو تا مساله هست. یکی داره اپ اسکیل میکنه. مزیت: راحتی ااستفاده هست ولی کارایی کمتر ولی کیفیت چی.این نسخه اولیه هست . خود dlss هم تا ورژن 2 خیلی چیز جالبی نبود.

اگر AMD بطور مستمر بهبودش بده شاید برای نسل بعدش بتونه رقابت کنه.

بالا اشاره کردم موتور RE کلا vram بالایی می خواد , RE3 یه بازی خطی اما در 4K داره 7.4 گیگ مصرف می کنه

--

2008 تا همین اواخر فراموش کردین بازی های که انویدیا همکاری می کردن چه عمکلرد فاجعه ای روی کارت های AMD داشتن ؟

---------

3080 و 5600X

View attachment 205355View attachment 205354

در مورد افزایش سرعت AMD

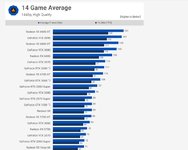

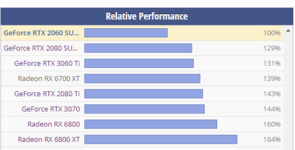

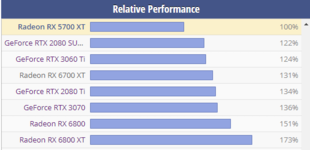

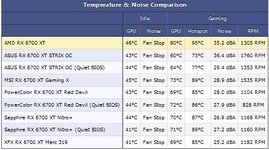

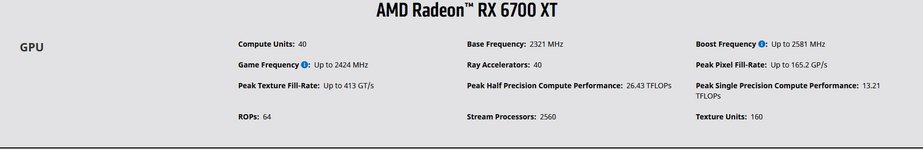

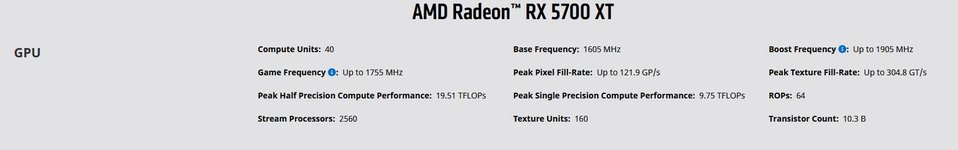

RX 6700XT با 2560 شیدر حدود 30 درصد بهتر از RX 5700XT که اون هم 2560 شیدر و 241 درصد بهتر از RX 580 که 2304 شیدر بود

3060TI با 4864 کودا حدود 30 درصد بهتر از 2060S با 2174 کودا و 234 درصد بهتر از 1060 که 1280 کودا داشت

عملا AMD معجزه کرده

سه سال پیش رسیدن به کلاک 1600 برای AMD ناممکن بود , امروز کلاک معمول RX 6700XT حدود 2550

مشکل سرعت پیشرفت AMD نیست , AMD همین الان از نظر قدرت rasterisation شیدر ها انویدیا پشت سر گذاشته

انویدیا بیش از یک ده است روی ray tracing , هوش مصنوعی و machine learning کار می کنه و میلیارد ها دلار هزینه کرده و موفق شده زمین بازی کلا تغییر بده

دیگه امروز قدرت rasterisation اهمیتی نداره , مهم ray tracing و machine learning

هیچ دکمه جادویی وجود نداره که AMD یک باره به سطح انویدیا برسه ,AMD هم باید سالها کار کنه و میلیارد ها دلار هزینه کنه و احتمالا 2023 به سطح قابل قبولی می رسه

نتایجش خوبه ولی ویرایش نمیکنه.Metro Exodus Enhanced Edition тест GPU/CPU | Action / FPS / TPS | Тест GPU

من این سایت روسی رو خیلی قبولش دارم چون روسی هست پولی از کسی نمی گیره و نتایجشم اکثرا با نتایج خودم یکسانه

منبع درصد ها سایت techpowerupغیر از معجزات amd ، معجزات بازیسنتری هم داریم که واقعا، بی نظیرن و علوم جدیدی رو به ما می آموزند.

View attachment 205401View attachment 205402

که 108/72 میشه 50 که همون حدود 30 درصده اختلاف 3060ti و 2060s هست

یا 60/41 میشه 46 که همون حدود 30 هست

_______________

به سایر معجزات نمیپردازیم، چون که بحث در موردش زیاده، ولی همین بس که

2060s نسل قبل با قیمت 399 دلار میاد و امسال رو همون قیمت با حدود 30 درصد افزایش قدرت ( ریاضی بازیسنتری) کارت 3060ti میاد

6700xt با 30 درصد افزایش قدرت نسبت به 5700xt ( بخونید با 38 درصد اور فرکانس نسبت به نسل قبل) میاد ولی با افزایش 80 دلاری.

معجزه گر رو خودتون پیدا کنید. معجزه به اور فرکانس نمیگن، به این میگن که بتونی با حداقل افزایش قیمت، بیشترین بهره وری رو بدست بیاری.

به معجزات amd تو مباحث ری تریسینگ هم اصلا وارد نشیم بهتره

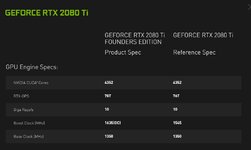

2080ti هم فرکانسش 1545 هست تا 2400 هم فرکانسشو اور کردن و هیچ چیزی نشده. تازه اون 14 بوده و این نسل 8

ولی یچیزی وجود داره به نام سیستم خنک کننده، که نیازه یه کارته وقتی فرکانس بالا میره هسته ها زیاد میشن باید ارتقا پیدا کنه.

ارتقا هم یعنی هزینه. انویدیا نخواسته اینکار رو کنه و هزینه رو مدیریت خواسته بکنه و باعث شده 3060ti با 80 دلار ارزونتر کارایی تقریبا برابر با 6700xt و برتری معنادار تو ری تریسینگ داشته باشه.

_______________________________________

معجزاتی که شما پیدا میکنید بدرد تاپیک vs میخوره نه اینجا.

گرامی میشه بپرسم 3 تا اخرین کارت گرافیکی که داشتید چی بوده ؟ و قصد دارید چه کارت گرافیکی بخرید برای این نسل ؟ (البته اگر هنوز نخریدید )منبع درصد ها سایت techpowerup

View attachment 205433View attachment 205435

اگه اعتراضی داری برو ایمیل بزن

بعد این همه سال هنوز هم تفاوت فرکانس پایه و اورکلاک متوجه نشدی ؟

فرکانس معمول 2080ti بین 1800 تا 1950

بهترین 2080ti دنیا 1965mhz

MSI GeForce RTX 2080 Ti LIGHTNING Z review

حداکثر اورکلاک بین 2050 تا 2150

---------

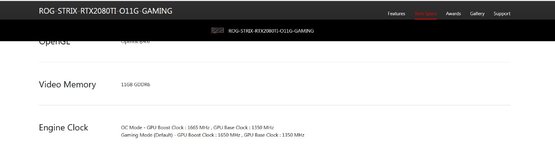

نسخه رفرنس rx 6700xt حدود 2500

View attachment 205437

AMD Radeon RX 6700 XT (reference) review

55 درجه

Powercolor RX 6700 XT Hellhound Spectral White review

اورکلاک این کارت 2850MHz و بالاتر

---------

قیمت گذاری ارتباطی به بحث بهبود خارق العاده شیدر های amd نداره

amd در شرایط عادی کارت در همین حدود 400 دلار قیمت گذاری می کرد , دوستان amd دیدن با هر قیمتی قرار بدن مهم نیست و نتیجه اش همین قیمت عجیب 479 دلار

-----------

RX 6700XT با 2560 شیدر بهتر از 3060TI با 4864 کودا عمل کرده

4 سال پیش 1060 با 1280 کودا عملکردی مشابه rx 480 با 2304 شیدر داشت

این معجزه amd

--------------

در مورد rt / ml هم گفتم

انویدیا بیش از یک ده است روی ray tracing , هوش مصنوعی و machine learning کار می کنه , هیچ دکمه جادویی وجود نداره که AMD یک باره به سطح انویدیا برسه ,AMD هم باید سالها کار کنه و میلیارد ها دلار هزینه کنه و احتمالا 2023 به سطح قابل قبولی می رسه